基于扩散模型的数据合成与压缩

本课题旨在探索高效数据合成与压缩(Efficient Data Synthesis and Condensation)技术在传递模型知识、提升SFT质量、降低训练成本方面的潜在应用。

工科

SCI

CCF

计算机科学与技术

人工智能

机器学习

数学

申请匹配

咨询客服 课题详情

【课题推荐发表期刊】

【课题背景】

随着大规模预训练模型(如GPT-4、LLaMA、T5)的发展,微调(SFT, Supervised Fine-Tuning)在适配特定任务和领域知识时变得至关重要。然而,SFT依赖于高质量、大规模的数据集,这不仅增加了数据收集与标注的成本,还对存储和计算资源提出了极高的要求。

本课题旨在探索高效数据合成与压缩(Efficient Data Synthesis and Condensation)技术在传递模型知识、提升SFT质量、降低训练成本方面的潜在应用。核心目标包括:

1. 合成数据驱动知识传递:通过生成 高质量的合成数据,有效复现大模型内部的知识分布,使小规模数据集仍能涵盖关键信息,减少对真实数据的依赖。

2. 优化高质量 SFT 数据:利用合成数据增强 监督微调(SFT) 过程,改善长尾分布问题,并提升模型在特定任务上的泛化能力。

3. 降低训练成本:通过数据蒸馏(Dataset Distillation)与扩散模型技术,减少训练所需数据量,从而降低计算需求、加快模型训练速度,并提升存储与传输效率。

本研究的核心方法包括基于基础模型的知识蒸馏、生成式数据增强(基于扩散密性) 以及信息压缩优化,最终目标是构建一个低资源、高质量、高适配性的数据合成与训练框架,为模型部署、私有化训练、联邦学习等场景提供高效解决方案。

【课题方向参考】

基于influence loss和memory bank改进扩散模型在推理阶段的数据生成,提高下游分类任务的性能

应用SOTA的统一图片生成和理解模型在下游的image retrieve任务,探究新模型生成高质量合成数据的潜力

利用数据集剪枝技术,挑选出原始数据集的代表性样本,并在隐式空间进一步巨累,指导生成模型进行定向数据合成,利用新的合成数据提升基础模型性能

【适合人群】

熟悉Pytorch框架,完整跑过深度学习模型训练,计算资源能够至少支撑ImageNet-1k的训练(4X 4090 或者2X A100/A800)。

【课题收获】

高质量论文一篇(SCI/CCF定向期刊)

SCI/CCF期刊投递与发表指导

结业证书

【导师介绍】

Dr. Shi,QS20高校博士,顶尖研究所高级科学家

累计发表近20篇CCF-A,其中一作9篇

担任TMAPI、ICML、NeurIPS、ICLR、CVPR审稿人

辅导过9名学生,其中研究生5名,博士生4名;专注机器学习三大会,指导过研究生新生发NeurIPS, CVPR

善于挖掘新研究思路,从新颖的角度展开研究

可提供申博指导、海外高校申请指导;可提供开源代码并指导复现;可提供部分开放研究数据;可撰写推荐信;就业/实习机会推荐

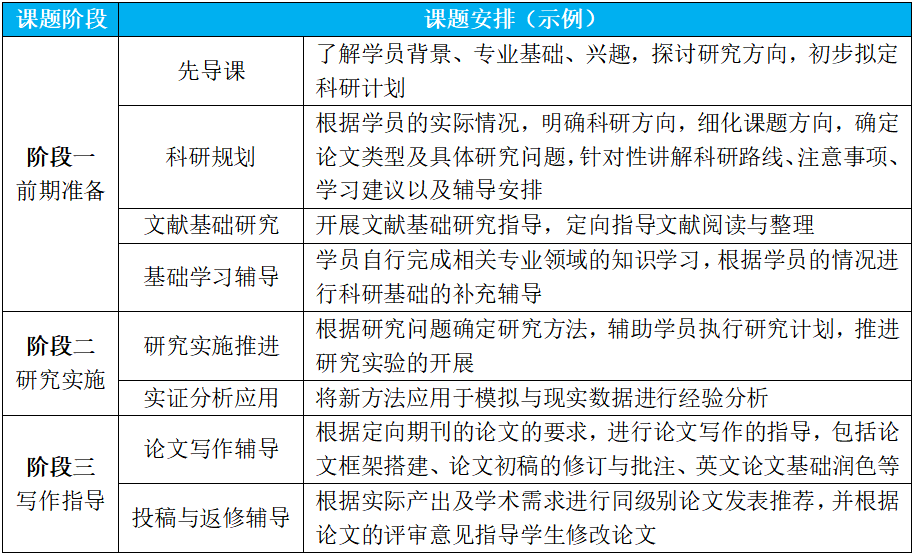

【课题安排】

研究周期预估六个月左右,具体视学员情况调整。

【推荐阅读】

课题导师 查看详情 >

石砚KY16652

QS10高校博士,顶尖研究所高级科学家

机器学习计算机视觉对抗攻击数据综合优化算法

立即添加好友,了解更多